トークン性能、消費電力でGPUを圧倒するSambaNovaのAIプロセッサ

高効率で消費電力当たりのAI処理性能が高いAIチップの中で、NvidiaのGPUと張り合えるチップはそう多くない。データフローコンピューティングアキテクチャであり、さらにダイナミックにエージェントがジョブを切り替えられる方式のSambaNovaのチップはその候補の一つ。推論性能で他社を圧倒する結果をこのほど発表している。

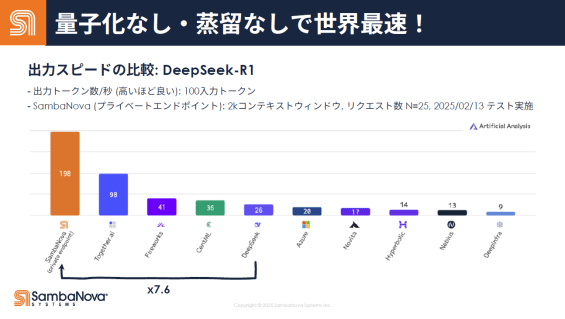

図1 Artificial Analytics社のベンチマークでの比較 SambaNovaのコンピュータ(左端)が最も高速だった 出典:SambaNova Systems

SambaNova Systemsが示したのは、今をときめくDeepSeek-R1-671B(6710億パラメータ)を使ってMixture of ExpertsモデルのベンチマークをArtificial Analytics社がさまざまなコンピュータと比較したもの。その結果、SambaNovaのコンピュータが最も速い出力速度(198トークン/秒)だった(図1)という。このベンチマークではDeepSeekのコンピュータより7.6倍、Microsoft Azureより9.9倍速い。SambaNova以外のコンピュータは、NvidiaのGPUを使っていると見なせる。

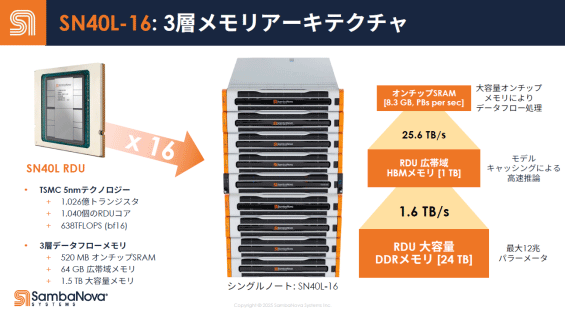

SambaNovaのシステムは、これまで報告してきたように(参考資料1、2)、1026億トランジスタを集積したデータフロー型プロセッサであるRDU(Reconfigurable Dataflow Unit)コアを1040個集積している。基本的に16ビット固定で推論するシステムであるため、生成AIのような巨大なパラメータのモデルを推論する場合には効率の高い大きな計算能力が必要になるが、SambaNovaのシステムSN40L-16ではRDUを16枚搭載した1ラックのシステム。プロセスはTSMCの5nm技術を利用した。

RDUではニューラルネットワークと同様、ニューロンが無数に並んだレイヤーを計算した後、次のレイヤーにある無数のニューロンを演算し、さらに次のレイヤーに行く、といったデータフロー方式で計算する。計算処理用のメモリ(データと重み)はオンチップであるため、チップ外の長い演算パスを通らない。このため効率が良く、消費電力が少ない。

一つのRDUでは、メモリを3層構成にして、オンチップのSRAMは、データフロー処理するためのメモリで、容量は520MB。2番目には64GBのHBM(High Bandwidth Memory)メモリで、高速で推論するためモデルをキャッシングしておく。3層目が1.5TBの外部のDDRメモリである。

1枚のRDUを16枚搭載し、それをラックに納め、今回性能を実証した。このためメモリの階層構成は、オンチップの第1層が8.3GB、プロセッサの周囲に配置されている第2層が1TBでその速度は25.6TB/s、最大12兆パラメータを扱える3層目が24TBの要領で、その速度は1.6TB/sとなっている(図2)。

図2 AI専用チップのSN40L RDUを16枚搭載したコンピュータラック 出典:SambaNova Systems

この1ラック構成のAIコンピュータで4種類のLLM(大規模言語モデル)のトークン処理を、最速のGPUを搭載したコンピュータと比較した。その結果、10億パラメータでは約8.1倍の2477トークン/秒/ユーザー、80億パラメータでは11.4倍の1066トークン/秒/ユーザーとなった。規模が大きくなるにつれその差は広がり、700億パラメータでは14.4倍の460トークン/秒/ユーザー、4050億パラメータでは14.3倍の200トークン/秒/ユーザーとなった。

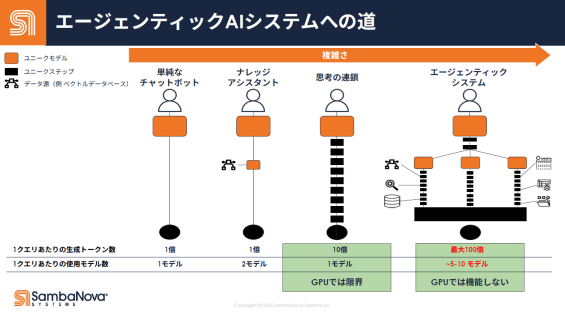

SambaNovaのコンピュータの特長はこれだけではない。1クエリ(問い合わせ)当たりの仕様モデル数は、従来のコンピュータなら1モデルだったが、SambaNovaのコンピュータではAIエージントを導入しており、AIエージェントが5〜10モデルをダイナミックに切り替えることができる。いわばさまざまなマルチのジョブを切り替えながらAI処理してくれるという訳(図3)だ。将来、例えば、経理処理した後に財務管理処理へとエージェントが自動的にAI処理することになる。

図3 1チップ内にジョブをAIエージェントが次々と切り替えられる仕組みを作った 出典:SambaNova Systems

同社の創業者は、CEOの台湾系Rodrigo Liang氏と共同創業者でチーフテクノロジストのKunle Olukotunスタンフォード大学教授、共同創業者のChristopher Re氏スタンフォード大学教授の3名で、エグゼクティブ会長にLip-Bu Tan氏(新Intel CEO)という、しっかりしたメンバーが付いている。RDUのReconfigurableという意味のエージェントがダイナミックにモデルを切り替えるという技術はスタンフォード大学が開発したものだという。

日本オフィスでも、アジア太平洋地域担当副社長の鯨岡俊則氏は、NEC、サン・マイクロシステムズ、Arm社を経験してきたコンピュータの専門家であり、アジア太平洋地域マーケティング・ディレクターの林憲一氏は、Nvidiaをはじめとして日米中のAI関連企業、さらに信州大学特任教授を経験してきたAIの専門家だ。テクノロジーはしっかりしていると言えそうだ。出資企業には、ソフトバンクグループやIntel Capitalに加え、メモリのトップ3社も加わっている。

参考資料

1. 「ニューロAIはデータフローコンピュータに乗ってくる時代になるか」、セミコンポータル、(2024/02/08)

2. 「スタートアップSambaNova、次世代AIのエージェンティックAIを実現」、セミコンポータル、(2024/07/26)