全盲者に福音、道案内ロボットを日本科学未来館などが実証実験へ

全盲の方々の盲導犬の代わりになりそうなナビゲーションロボット「AIスーツケース」を日本科学未来館と次世代移動支援技術開発コンソーシアムが共同開発、実証実験を始めた。このロボットは、スマートフォンと連動させ、スマホを通して周囲の状況をイヤホンから音声で教えてくれる。ロボットの方が半歩前に出るように動き、目的地まで道案内する。

図1 日本科学未来館と次世代移動支援技術開発コンソーシアムが共同開発したスーツケース型ナビゲーションロボット

開発したコンソーシアムは、オムロン、アルプスアルパイン、清水建設、日本IBMの4社が正会員となっている組織で、これまでも全盲の方たちが健常者と同じような生活を送れるようなテクノロジーを開発してきた。今回開発の主体は未来館が担った。実は未来館の館長である浅川智恵子氏は、全盲で元IBMのフェローでもあり、AIをはじめIT技術に秀でた人物。彼女がナビゲーションロボットのテクノロジーをけん引してきた。

このロボットは、一般のスーツケースとほぼ同じ大きさながら、AIや生成AIが詰まっている。実際に動かす場合にはスマホに目的地を設定し、始動すると目的地までの道案内をしてくれる。スーツケースの最も上のグリップがハンドルになっており、左右への移動や停止、始動などはハプティクスなどで知らせてくれる。目的地へ着くと自動的に止まると同時に音声でも教えてくれる。屋内でのデモの様子は動画でも見ることができる(参考資料1)。

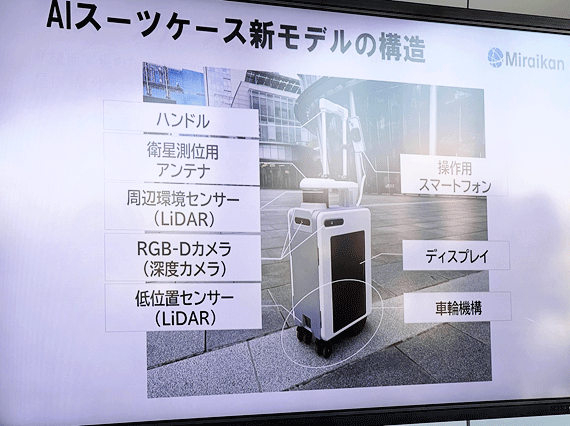

搭載されているテクノロジーのセンサ部分が大きなカギを握っており、まず、自分の位置を確認できる衛星測位用のアンテナがスーツケースの上にある。その下に周囲を見るセンサとしてのLiDARがある(図2)。スーツケースの全面と両側面の3方向にはカメラがある。スーツケースの側面に一応ディスプレイも付いているが、ここではLiDARの様子などを表示する。このディスプレイに表示された情報は未来館の中のセンターにつながっており、異常があれば駆けつけることができる。

図2 ナビゲーションロボットには多数のセンサが付いている

実際に周りに何があるかを面出するのはRGBセンサに深度センサを搭載したカメラ(図3)が前方、左方向、右方向をそれぞれ見て、内部のエッジAIがそれらの画像を判別する。深度センサでは周囲にいる歩行者との距離を測定している。

図3 スーツケースの側面にもカメラが搭載されており捉えた物体をAIで認識する

さらにNvidiaのGPU(製品名ORINかもしれない)も搭載しており、このGPUは安全に移動できるルートを計算する。さらに、このロボットに何かを質問する場合には、4Gネットワークを通したクラウドベースで生成AI を経て、回答してくれる。

実際に屋外でデモした時は、バスケットボールを持った人が前方から歩いてくると、「バスケットボールを持った人が近づいてきます」と音声で教える。ここでは人間だけではなく、バスケットボールも学習しており認識できているため、より正確に前方の人の情報となっている。

まるで盲導犬と同様だが、このロボットが完全に盲導犬と代替できるというわけではない。盲導犬は山を登ることができるが、このロボットは舗装された道路が主体であり、砂利や石の多い山登りはできない。しかし車道から歩道への道路の段差程度なら、ロボットを少し斜めにするだけで上ってくれる。また、階段は昇降できないものの、下りる階段あるいは上る階段の前に来るとロボットは止まってしまうため、エレベータのある所まで迂回する必要はある。

これまでの試作品で実証実験を繰り返してきたが、2025年4月から開催される大阪・関西万国博覧会の会場において複数台運用し、さらに運用のデータを吸い上げ、商用化につなげていく。万博会場での貸し出しは予約制で、一般客も使えるという。

参考資料

1. 「AIスーツケースについて」、日本科学未来館ホームページ