Nvidia、最新GPU・CPU・ネットワークチップで世界最強のコンピュータを作る

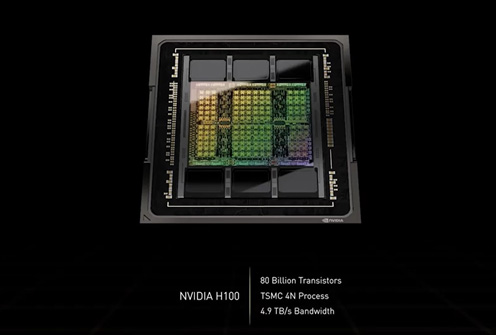

GPU(グラフィックスプロセッサ)メーカーのファブレス半導体Nvidiaが800億トランジスタを集積、TSMCの4nmプロセスノード(4N)で製造した次世代GPUとなるNvidia H100(図1)を開発した。今週開催されているGTC(GPU Technology Conference)2022の基調講演で、同社CEOのJensen Huang氏が明らかにした。パッケージングにもTSMCのCoWoS技術を使った。

図1 800億トランジスタを集積したGPU 出典:Nvidia

ブランド名「Hopper」と呼ぶH100チップの最大の特長は、拡張性を持たせ、そのまま台数を増やせるようにクラウドやデータセンターなどのITインフラに合わせて設計していることだ。特に、80GBのメモリ容量、メモリバンド幅、チップ内・チップ間を接続するネットワーキング、NVLinkチップ同士のデータレートが低下しないように設計したという。

図1で見えるように虹色に輝くチップの上下に6個のHBM(High Bandwidth Memory)3メモリが配置されており、このH100が最新規格のHBM3を初めて採用する製品となる。6個1組のメモリのI/O帯域幅は40 Tera-bits/sと極めて広い。ちなみに現在世界のインターネットウェブのトラフィックは、H100チップ20個分に相当する、とHuang氏は述べている。この広いバンド幅で第5世代のPCIeを採用した最初のGPUでもあるという。

このチップはAI(機械学習やディープラーニング)動作には最大限の考慮をしている。今回、8ビット浮動小数点演算FP8にも対応、4 PetaFLOPS(Floating point Operations per Second)の性能を得ている。PetaはTeraの1000倍で、Gigaの100万倍である。これまでのA100同様、FP16、FP32、FP64にも対応、性能はそれぞれ2 PetaFLOPS、60 TeraFLOPSとなっている。今回のHopper H100チップの性能は、従来同社のAmpere A100のFP16と比べて、FP8で6倍高い。

加えて、AIのディープラーニングモデルTransformerも開発、実行するための専用エンジンTransformerエンジンも集積した。このエンジンは新たに追加したFP8とFP16の数値演算形式を使い、高度なソフトウエアアルゴリズムを組み合わせると、これまで数週間もかかっていたような膨大なパラメータのAIモデルを数日で演算できるようになる。カスタム仕様のHopper Tensor コアは、AIの演算をFP8とFP16をダイナミックに切り替えられる。FP8は精度が粗いものの演算は速い。FP16は精度が2倍高いが遅い。モデルのパラメータ演算でそれらをダイナミックに切り替えることで、精度と演算速度の両立を図ることができたとしている。

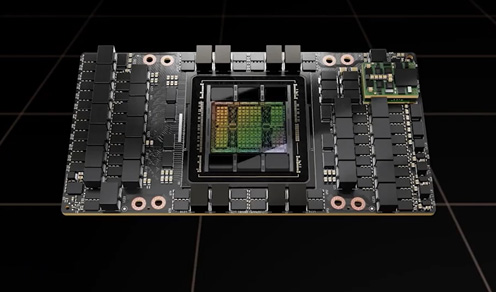

図2 GPUチップH100をボードに実装したモジュール 出典:Nvidia

800億トランジスタのH 100 GPUチップは、TSMCがCoWoS(Chip on Wafer on Substrate)と呼ぶ 2.5DパッケージとHBM3メモリ、さらに定電圧レギュレータをSXMと呼ぶスーパーチップモジュールに集積されている(図2)。CoWoS技術は前世代のA100でも使われた。

Nvidiaはファブレス半導体メーカーでありながら、コンピュータまで作り上げている。今回はDGX H100というAIコンピュータを示した。8個のH100 SXMモジュールがHGXボード上に搭載され、4個のNVLink スイッチチップでGPUを接続している。各NVLinkスイッチ チップには3.6TFLOPSのSharpインネットワークコンピューティングが内蔵されている。これは買収したMellanoxのInfiniBand スイッチをベースに発明されたもの。Sharpはバンド幅を効率よく3倍まで広げることができるという。

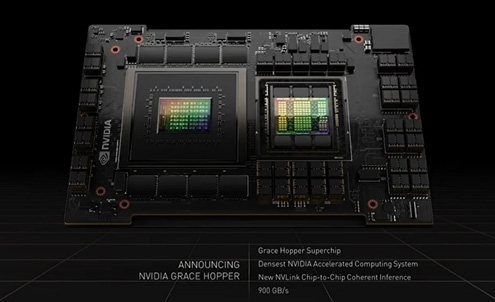

図3 Grace CPU Superchipと呼ばれるGPUを制御するためのCPU 出典:Nvidia

DGX H100には8個のGPU全体を制御するためのCPUが必要となる。Huang氏はCPU製品としてGrace CPU Superchipと名付けたCPUを開発(図3)、2チップ構成でDGX H100を制御する。拡張性も持たせているため、2チップ構成で最大8個のH100 GPUを制御したのがサーバーDGX H100である。2個のCPUは、900GB/sのNVLinkでつながっており、メモリバンド幅1Terabyte/sを実現している。このCPUには144個のコアが集積されている。

GPUチップ間を接続するのは、2個のネットワークモジュール。これは、それぞれ4つの400Gbps CX7 IBか、400Gbpsイーサネットワークチップを備えている。Connect X-7はネットワークスイッチであり、400 Gbit/sでGPUチップ間を接続する。CX-7チップはTSMCの7nmプロセスで作られた80億トランジスタを集積している。

AIコンピュータ、DGX H100には8個のGPUボードが接続されており、それらはNVLinkスイッチで接続されている。AI性能として、32Peta FLOPSと驚異的な高さであり、搭載されたHBM3メモリは640GBにも及ぶ。そのメモリバンド幅は24 TeraBytes/sと広い。

このDGX H100コンピュータには拡張性があり、NVLinkでは最大32台のDGXを接続できる。ここにNVLink スイッチシステムを利用すると、一つの巨大な32ノードの256 GPU DGX PODにスケールアップできる。20.5 Tera バイトメモリのHBM3と、768 Terabyte/sのメモリバンド幅というとてつもない巨大なシステムになる。ちなみにインターネット全体のバンド幅が100Terabyte/s だという。こうしてできたDGX PODのAI性能は、1 Exa FLOPSにもなる。

さらに、このDGX PODを18台接続したスーパーコンピュータEos(イオス)を評価してみると、AI性能は、18.4ExaFLOPSとなり、日本のスパコン「富岳」の4倍の性能になる。Eosでは、576台のDGX、4608個のH100 GPUが搭載されている。

参考資料

1. "NVIDIA H100 Tensor Core GPU Architecture", Nvidia Whitepaper