Cerebras、4兆トランジスタの第3世代ウェーハスケールAIチップを開発

Cerebras Systems社は、4兆トランジスタを集積したウェーハスケールのAIアクセラレータチップ「WSE-3」を開発した。300mmウェーハから21cm角に切り取った半導体で、前回のWSE-2(参考資料1)での7nmから5nmプロセスを利用して集積度を上げた。このウェーハスケールICを組み込んだAIコンピュータ「CS-3」を64台組み込む「Condor Galaxy 3」を戦略的パートナーであるG42と共同で開発中である。

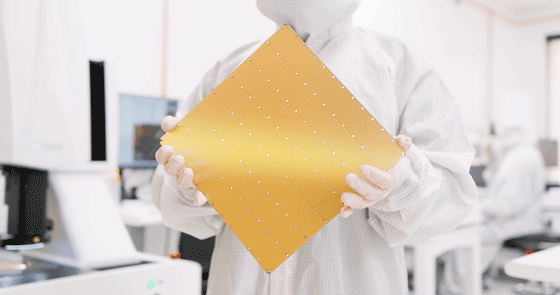

図1 第3世代のウェーハスケールIC「WSE-3」を開発 出典:Cerebras Systems

ウェーハスケールIC「WSE-3」を搭載したAIコンピュータCS-3の性能は、これまで最高のCS-2と同じ消費電力、同じ価格で比べると性能は2倍になっているという。このコンピュータCS-3は、最も巨大なAIモデルを学習させることを目的としたマシンで、最大24兆パラメータのAIモデルを学習させることを狙っている。同社のウェーハスケールAIチップは、第1世代が16nm(参考資料2)、第2世代7nm、第3世代が5nmとやってきた。5nmプロセスのICファウンドリはTSMCだと、このAIチップを搭載したコンピュータを製作しているG42がニュースリリースで述べている(参考資料3)。

ウェーハスケールICのチップ面積は46,225mm2と巨大で、スパース線形代数(ゼロの多い疎行列)に最適化された90万コアが集積されている。AIコンピュータとしての性能は125 Peta FLOPS(1Petaは10の15乗)、オンチップメモリの容量は44 GB、外部メモリ(HBM)は1200 GBで、メモリのバンド幅は21 Peta Bytes/sとなっている。

Cerebrasはまた、AIアクセラレータCS-3を学習用に使い、QualcommのクラウドAI 100 Ultraを推論用にAIを使えば、約10倍のコスト・パフォーマンスが得られたとしている。

アブダビを拠点とするAIコンピュータ企業のG42社は、CerebrasのAIチップWSE-3を搭載したAIアクセラレータ「CS-3」を64台並べたAIコンピュータ「Condor Galaxy 3」を試作した。CG 3には約5800万個のAIに最適化したコアを備え、16 Exa FLOPS(Floating Operations Per Second)という超高性能を発揮すると見積もっている。Exaは10の18乗を意味する単位。

2023年11月現在における世界のスーパーコンピュータランキングTOP500で最も高速のスパコンは、米Oakridge 国立研究所の1.1 Exa FLOPSであるから、CS-3はその1桁上の性能となる。ちなみに日本の富岳は昨年に続き第4位の0.44 Exa FLOPSとなっている。

「Condor Galaxy 3」を使えば大規模言語モデルLlama-70B(700億パラメータ)を学習させるのにわずか数日で済むという。1750億パラメータのLLMであるGPT-3をNvidiaのGPUであるA100では学習するのに300日かかったと言われている。

これまでのCondor Galaxy 1と2は、米国カリフォルニア州に設置されているが、Condor Galaxy 3はテキサス州ダラスに設置される予定だという。

CerebrasのCS-1とCS-2のAIアーキテクチャは、従来のフォンノイマン型コンピューティングではなく、ニューラルネットワークのワークフローと同様、データフローコンピューティングである。CS-3もそのアーキテクチャを採用していると思われるが、明らかにしていない。

参考資料

1. 「7nmプロセスで製造したウェーハ規模の巨大なAIチップ」、セミコンポータル (2021/04/28)

2. 「Cerebras社、ウェーハ規模のAIチップを実装したコンピュータを発売」、セミコンポータル (2019/12/20)

3. "G42 and Cerebras Break Ground on Condor Galaxy 3, an 8 exaFLOPs AI Supercomputer", G42 (2024/03/13)