Cerebras社、ウェーハ規模のAIチップを実装したコンピュータを発売

AIチップのスタートアップ、米Cerebras社の巨大なウェーハスケールAIチップを8月に紹介したが(参考資料1)、Cerebras社はこの21.5cm×21.5cmというこのチップを組み込んだAIアクセラレータエンジンCS-1を日本で販売するため、東京エレクトロンデバイスと提携した(参考資料2)。

図1 Cerebras社創業者兼CTOのGary Lautherbach氏

このほど来日したCerebras社の創業者兼CTOのGary Lautherbach氏(図1)は、このウェーハスケールLSI(図2)に対して、「歩留まりは100%である。配線は冗長構成を取っているからだ」と述べる。この考え方は参考資料1で紹介したように、40年前のウェーハスケールLSIとは全く違う。当時は、ロジックの一つが不良になるとチップ全体が不良となり、歩留まりはほとんどゼロに近かった。このため実用化できなかった。しかし、ニューラルネットワークでは、あくまでも多入力1出力の演算器で1個のニューロンを表現でき、しかも神経ラインが1本くらい切れていても、迂回路を通すことが可能だ。しかも全体(人間なら200億ニューロン)で見れば1個や2個の不良は無視できる。このチップのニューロン数は明らかにしなかったが、全体で1兆2000億トランジスタもあるため、かなりの数のニューロン数ではあろう。

図2 Cerebras社マーケティング担当Andy Hock氏が持つチップ

ニューラルネットワークでは、一つのニューロンに対して10本程度の信号が入力され、出力は1本だけであり、その値は1か0である。10本程度の信号それぞれに重み(0〜1)を掛けるため、デジタルで表現すると10個のMAC(積和演算)になる。その答えが1か0ということは、多数のMAC演算には「0×重み=0」という演算が極めて多いことになる。MAC演算は行列でも表現できる線形代数であるが、行列要素の中身の多くはゼロになるため、このSparse(疎)部分の計算を省略できる。こうすると、演算回数を減らせる。CerebrasはこのSparse演算を省略することで電力効率を上げた。

ただし、このチップはNvidiaのGPUよりもはるかに高い性能(実験では数百倍〜1000倍)になっており、学習させるためのAIチップであり、重みを浮動小数点で表し、32ビット以上の演算精度で少なくとも学習精度を上げることができる。

また、MAC演算器はメモリ(RAM)に近いほど演算速度が上がり、消費電力も下がる。チップ全体に集積したメモリは18GBのSRAMだが、AIコアと称するAI演算ブロックは汎用のフォンノイマンコンピュータであり、ここには48KBのローカルメモリを持っているという。AIチップにおけるメモリの役割は、MAC演算した結果を一時保存し、次のニューロンへ送るべきデータを読み出すために使われる。さらに、必要な重みを表す小数点の数字を保存する役割もある。つまり、MAC+RAMのセットこそ、AIチップの本質である。ここでは、AIコアでの重み演算には、多数の浮動小数点演算ができるようになっており、その動作には1GHz以上のクロックを使っているという。

さて、ウェーハスケールのシリコンをどうやってパッケージするか。これだけ大きなチップは発熱も大きいため、シリコンの熱膨張係数と同じ程度の材料を使わなければ、発熱による温度差でシリコンが割れてしまう恐れがある。この問題に関して4年以上も費やして解決し独自の専用パッケージを開発した、とLautherbach氏は述べている。関連する多数の特許も取得している。

チップの消費電力は20kWと通常のチップよりははるかに大きい。このため熱を素早く逃がすための放熱に対しては、チップの両面から閉ループで水冷しており、さらにシステム全体には空冷するという両方の冷却法を用いている。

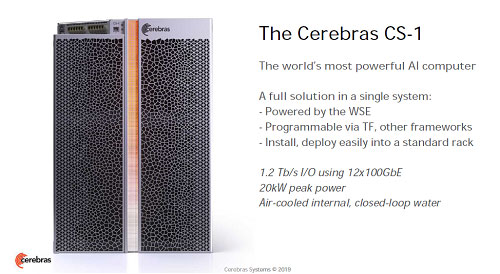

このチップを1個だけ搭載し、電源や制御系も含めたAIコンピュータCS-1(図3)を開発した。100Gビット/秒のEthernetを12レーン用いたI/Oの速度は1.2Tb/sと極めて速い。CS-1は、標準の19インチラックで15U相当の大きさに収められている。

図3 開発したAIコンピュータCS-1 出典:Cerebras Systems

そしてディープラーニングのアルゴリズムや機械学習のフレームワーク(TensorFlowやPyTorchなど)でプログラムできるようなソフトウエアプラットフォームも提供する。APIで自由にカスタマイズできる。ソフトウエアスタックを全てのレイヤーに紐づけし同時に実行できるうえに全レイヤーを同時にコンパイルでき実行に移すことができる。

学習時間をこれまでの数カ月から数分に、あるいは数週間から数秒に短縮できるようになるため、これまで実用上あきらめていた精巧な大きなAIモデルを試すことができるようになり、AIソフトウエアエンジニアの活躍の場ができる。性能が1000倍速いということは、実際の学習セットでも1000倍のデータを扱うことができるため、もっと精巧なソリューションを高速に実行が可能になる。国内販売価格は未定だが、おおよそ数億円のレベルになるとしている。

参考資料

1. ディープラーニング学習にはウェーハ規模の巨大なチップが必要 (2019/08/27)

2. セレブラス社と販売代理店契約を締結、超高速ディープラーニングシステム「CS-1」の受注を開始 (2019/12/19)