Nvidia、1兆パラメータの生成AI向け新GPUとAIコンピュータを発表

半導体初の時価総額1兆ドル企業となったNvidiaの一大イベントであるGTC 2024が今週初めに米カリフォルニア州サンノゼで開催され、1兆パラメータを処理するための新しいAIチップ「GB200」を明らかにした。この製品は、新GPU「Blackwell」を2個とCPU「Grace」1個を集積したSiP(System in Package)。Blackwellも、2チップ構成となっており、GPU1個でも巨大なチップとなっている。なぜ巨大なチップが必要か。

図1 Nvidiaの創業者兼CEOのJensen Huang氏 出典:Nvidiaの講演スライド

GTCはかつてGPU Technology Conferenceと呼ばれていたが、基調講演に立ったNvidia社の創業者兼CEOであるJensen Huang氏(図1)は、GPU(グラフィックプロセッサユニット)という名称はもはや過去のものになりつつある、と述べた。GPUは、もともとCG(コンピュータグラフィックス)で絵を描くためのチップであったが、ニューラルネットワークモデルが実用化されて以来、単なる小さな積和演算器を大量に持つAIチップとしても使えた。GPUでは、デッサンにせよ、色塗りにせよ、1枚の絵を、小さなブロックに分割して、各ブロックを同時に並列動作させて描画するが、その各ブロックの演算がまさに積和演算であった。ニューラルネットワークのモデルと全く同様な線形代数の行列演算動作であったから、GPUがAIチップとしてそのまま使われてきた。

AIは生成AIに発展し、学習させるべきパラメータ数は、チャットGTPのベースとなるGPT-3で1750億パラメータにもなり、巨大な学習ソフトウエアとなった。GPT-3.5やGPT-4のように、さらなるパラメータ数の増加は、これまでのGPUではとても間に合わない。GPT-3の学習にはA100のGPUで300日かかったと言われている。さらに大きなGPT-4は1兆パラメータになるという。これでは学習に何年もかかってしまう。GPUの性能がもっと高くなければ処理できない。Nvidiaが昨年最高性能のAIチップ「Grace Hopper」を出したが、今年のGTC 2024では、さらに高性能なチップが登場した。

高性能なAIチップでは、ニューラルネットワークモデルに適した計算手法が求められている。GPUだけだと無駄な計算が多く、消費電力が大きすぎた。特に、ニューラルネットワークの積和演算ではa×0という計算が極めて多い。答えは0(ゼロ)に決まっているのにもかかわらずGPUでは全ての演算を「馬鹿正直に」行ってきた。そこで、Nvidiaは、昨年発表したH200(コード名Grace Hopper)というAIチップでは、a×0という計算が多い疎行列はCPU(Grace)で0という決まった数字に変換し、0ではない計算の密行列をGPUで行う方式をとった。

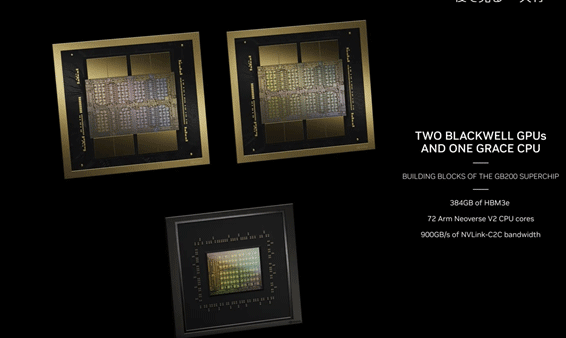

今回のAIチップ「GB200」(図2)に2個のGPU「Blackwell」とCPUを搭載したのは、疎行列と密行列をそれぞれが担当するためだと思われる。GB200の推論におけるAI性能は、これまで最高だったH100 の30倍にも上る。

図2 新しいGPUの「Blackwell」チップを2個と、Neoverse V2 CPUコアベースのCPUチップ1個で構成されるGB200 出典:Nvidiaの講演スライド

この新型GPUの「Blackwell」(図2の上の2個のチップ)に集積されたトランジスタ数は、これまで最大の2080億個にも上る。しかも各Blackwellは、さらに二つのダイに分かれており、2個のダイを一つのGPU製品と構成している。それぞれのダイはHBM3Eメモリを4個ずつ持ち、合計8個で384GBのメモリを持っている。CPUはArmの64ビットのデータセンター向けのNeoverse V2コアを72個集積したもの。最近Armはさらに高性能なNeoverse V3を発表している(参考資料1)。

AIスーパーコンピュータも提案

Nvidiaは1兆パラメータを処理するためのAIコンピュータも提案した。「Grace Blackwell スーパーチップ」と呼ぶGB200を2個、一つのコンピュータボード(コンピュートトレイと呼ぶ)に収め、このボードを18枚コンピュータラックに実装した。つまり、1台のコンピュータラックに72個のBlackwell GPUが搭載されている。それをNVLinkという高速インターフェイスで全てのGPUを接続する。この場合のメモリは全てのGPUがデータを共有するコヒーレント状態にしている。すべてのGPUをつなぐNVLinkでのチップ間のデータレートは900GB/sと極めて高速だ。コンピュートトレイのAI性能は80PetaFLOPSと高く、メモリ容量は1.7TB。

このコンピュータ「GB200 NVL72」はラックスケールになっており、80Peta FLOPSのコンピュートトレイが18枚で構成されているため、1.4Exa FLOPSというスーパーコンピュータになる。この性能は、日本のスパコン「富岳」のおよそ3倍の性能であり、現在TOP500で紹介されている最高性能のスパコン「Frontier」の1.2Exa FLOPS を超えることになる。1兆パラメータの生成AIにはこの程度の性能が求められるとしている。さらにこのコンピュータラックを大量に並べると、新時代のスーパーコンピュータのデータセンターが出来上がると見積もっている。このデータセンターのAI性能は645 Exa FLOPSととてつもなく巨大になる。

GPUやCPUを大量に並列動作させる場合には、もはやバス方式は使えないため、スイッチ方式でデータの流れを整理する必要がある。そこで、スイッチ用のNVLink用のICも開発している。NVLinkは最大576個のGPUを接続でき、総合的なバンド幅は1Peta B/sで、高速メモリ容量は240TBと大きい。

参考資料

1. 「Arm、クルマのデータセンター化に向けIPコアを充実」、セミコンポータル (2024/03/19)