生成AIだけがこれからのAIではない〜Intel、AMD、IBMの戦略から見えるAI

Intelのチップレットを多用した新しいSoCチップMeteor LakeはCPUとGPUとNPUから構成され、AIエンジンとなるNPUが確実に搭載されている。またAMDの最新チップRyzen PRO 7000シリーズにもAI回路が搭載されている。IBMが最近明かした生成AIは小規模から中規模の生成AIモデルをビジネスにすることを明らかにした。いずれも大規模言語モデルだけがAIではないことを見据えている。

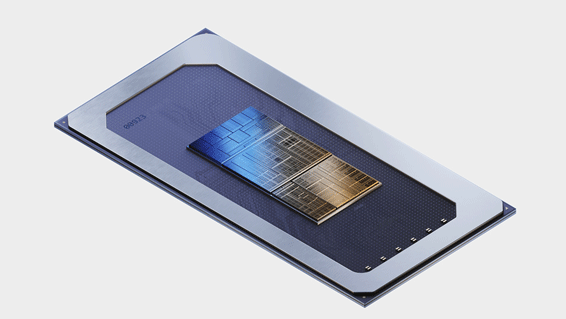

図1 Intelの新SoC「Meteor Lake」 出典:Intel

Intelの新型チップ(SoC)のCore Ultra(コード名Meteor Lake)はパソコン向けのチップだが、パソコン向けのSoCで初めてチップレットを搭載した(参考資料1)。つまり2.5D/3D先端パッケージを採用した初のパソコン向けの製品になる。これまでIntelのパソコン用のSoCには、Core i5やCore i7などCoreの先に「i」が付いていたが、この新製品はiを除き、Core Ultraと称した。チップの発売は今年の12月になる予定だ。

このCore UltraにはCPUとGPU、さらにNPU(Neural Processing Unit)を1パッケージに入れており(図1)、さらにメモリのチップレットをCPUなどの上に3次元実装している。チップ間にはEMIB(Embedded Multi-Die Interconnect Bridge)と呼ばれるチップをつなぐブリッジチップ(インターポーザと違って全面ではなく部分的に再配線層となる)を用いている。

AIチップであるNPUを標準装備していることが大きな特長である。これまでもAI専用チップを開発してきたIntelはサーバ用のプロセッサ(SoC)であるXeonプロセッサと共に使うことを前提に作られてきた。Intelは今回、パソコン用にもAIチップを集積することを示した。

パソコン用プロセッサにAIを集積することは実はAMDも示している(参考資料2)。AMDのチップはモノリシックであり、その規模はIntelのCore Ultraよりも小さい。従来なら小さなAIチップは推論、大きなチップは学習、と用途が分かれていたが、AIモデルの進化があり、パソコンのようなエッジにも学習可能なAIが搭載される時代がやってきた。AMDもIntelもパソコンにAIをのせ簡単ながら学習もできる機能を標準装備するようになる。

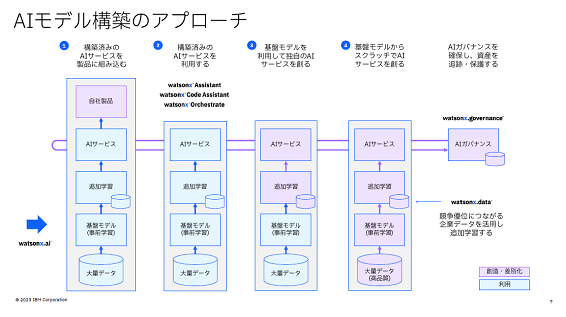

AIチップがこれまでとは異なる様相を示してきたのは、小さなチップでも学習できるようになってきたからだ。従来、学習はクラウドで、推論はエッジで行う、という常識が崩れている。クラウドで生成した学習データ(基盤モデル)を元に、追加学習だけで専用のAIモデルを作れるようになってきた。つまりパソコンやエッジでも追加学習させ、使えるレベルの推論を行うことができる(図2)。

図2 AIモデルを構築するための様々なアプローチ 出典:IBM

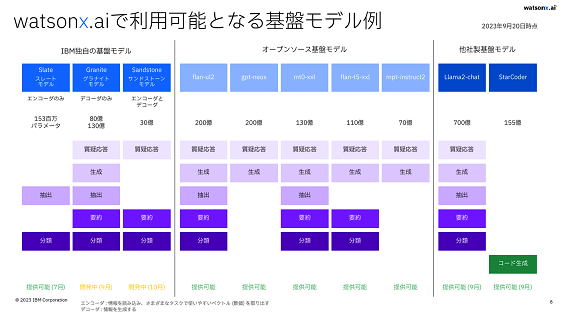

チャットGPTで代表されるような生成AIでさえも、大規模言語モデルのパラメータを巨大化するだけがこれからのAIではない。IBMはAIモデルや学習・推論に長年の実績を持つ企業だが、AIシステムであるWatsonをさらに充実させ、watsonxをベースに、チャットGPTのような1750億パラメータを使わなくてもユーザーの要求に合わせたAIモデルと用途に対応させるビジネスを推進している(図3)。

図3 IBMのwatsonx.aiで利用できる基盤モデル IBM独自からオープンソースまで使える 出典:IBM

watsonx.aiで利用できる基盤モデルとしてはIBM独自のモデルから、オープンソースになっている基盤モデルや、提供可能な他社のモデルなどを使えるようになっている。独自モデルでも1.5億パラメータから130億パラメータのモデルまであり、オープンソースでは最大でも700億パラメータに留まっている。しかもそれらの機能は万能ではない。大きなパラメータでは、質疑応答、生成、抽出、要約、分類という5つの機能を実行できるモデルだが、抽出と分類だけに特化すれば軽いソフトのモデルで済む。

IBMによると、AIには2つの流れがあるという。一つは、要約や翻訳に使うAIでは大規模言語モデルが必要で、クラウドベースで学習させるが、もう一つの企業向けのAIでは比較的軽いデータをターゲットにして学習モデルを更新する用途が多い。watsonxは追加学習で強化していくAIを狙う。

以上、Intel、AMD、IBMの戦略から見えることは、生成AIのような巨大な言語モデルはNvidiaのような基盤モデルを構築する場合に向いているが、AI用途はそれだけではない。もっと簡単に学習推論できるようなエッジ応用も広がっている。

参考資料

1. "Intel Innovation 2023: Empowering Developers to Bring AI Everywhere", Intel (2023/09/19)

2. 「AMDの新Ryzen PRO7040、AIエンジンやセキュリティプロセッサを集積」、セミコンポータル (2023/9/22)