Intel AI Everywhere戦略の第1弾、オフラインPC上で生成AIが可能に

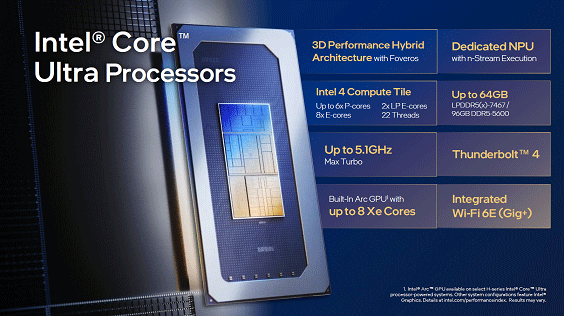

Intelは、AI Everywhere戦略を採ることを宣言した。その代表的な例としてAIエンジンを集積したパソコン向けCPU「Core Ultra(コード名Meteor Lake)」(図1)を発売するとともに、サーバー向けのCPU「第5世代のXeonプロセッサ」にもAIエンジンを集積した。さらにAI専用チップ「Gaudi 3」を2024年に発売することも明らかにした。

図1 Intelの最新SoCのPC向けCore Ultraプロセッサ 出典:Intel

IntelのAI Everywhere戦略のキモは、生成AIのような巨大なLLM(大規模言語モデル)から、パソコンのプロセッサや端末レベルまでAI技術が使えるようにすることである。AIは技術であり目的ではない。

AIは今やさまざまなところに使われ、これまでにない機能を作り出している。例えば、ST Microelectronicsは組み込みシステムに関する展示会Techno-Frontier 2023において、洗濯機にAIを用いて、使うモーターの最適な回転数に合った電流を流すことによって消費電力を削減した(参考資料1)。これはSTのマイコンにAI機能を集積している。もう一つの例として、Googleの最新スマートフォン「Pixel 8」シリーズには、AIを使ってズームインの解像度を上げている。これまでのカメラだとズームの拡大はレンズとデジタルズームの能力で決まってしまい、限界があった。それをズームインしてぼやけずに拡大できるという画素補完機能にAIで補完すべき形状を学習させて、別の写真を拡大してもくっきりと見えるようにした。

つまりAIは、もっと機能を拡大したい、あるいは性能を上げたい、処理時間をもっと短くしたい、などの要求に応える専用の機能を実現するための技術である。AI=賢い、何でもできる、という訳では決してない。学習させたことだけを実現する技術である。AIがパソコンやスマホに載るようになると、ちょっとしたさまざまな要求に応えられるようになる、逆に言えば、AIエンジンをマイコンやSoCに集積させることができるようになるため、パソコンやスマホ側ではどのような機能をAIで実現すべきかがシステム開発者には問われるようになる。

今回Intelがパソコン向けにAI機能を載せたプロセッサ(SoC:System on Chip)Core Ultraで簡単な生成AIをクラウドと接続せずに使えるようなデモを見せた。これは、絵を描くための生成AIであり、例えば「人物の印象派的な絵を描いてほしい」と依頼すると、そのような絵を出力し、その後「キュービズム的な絵を描いてほしい」と頼むとピカソのような絵を出力する、というデモであった。いずれも10〜15秒かかったが、インターネットとは切り離したデモであった。このCore Ultra製品は12月18日に国内で発売した。

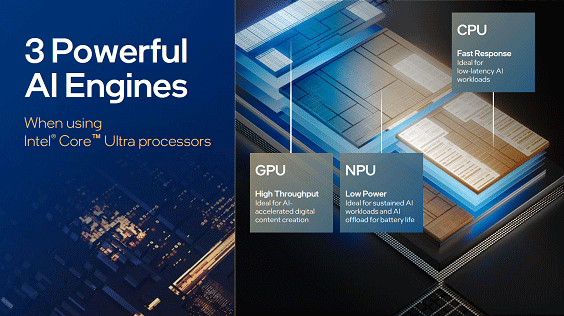

図2 CPUとGPU、NPUを1パッケージに実装 出典:Intel

このチップでは、CPUとGPU(グラフィックスを描く)、NPU(ニューラルプロセッシング)のチップを集積した先端パッケージに実装している(図2)。TSVを使った3D-IC技術Feverosを使い、3D-ICや2.5D-ICを使い、これまでのパソコン向けSoCよりも単位消費電力当たりの性能が高い。CPUには最大6コアのP-コア(性能優先のCPUコア)、8コアのE-コア(電力効率優先のCPUコア)そして、特に消費電力の低いLP E-コアを2コア集積した。GPUにはインテル独自のArcコアを使い、Ray Tracing回路技術を集積した。AI専用のNPUはニューラルネットのデータフローコンピューティングのストリームを実行するようだ。

生成AIで画像を出力するデモでは、LLMの一種であるLLaMa2-7Bモデルをオフラインで実行したが、CPUとGPU、そしてNPUを同時に割り振りながら実行している。LLMのEncoderモデルをNPUで実行したという。

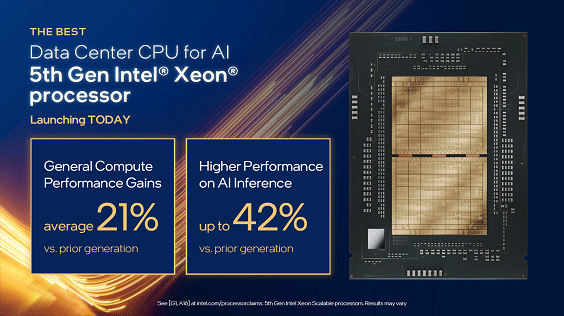

図3 第5世代のXeonスケーラブルプロセッサ 出典:Intel

発表したもう一つのSoCである第5世代のXeonスケーラブルプロセッサ(開発コード名Emerald Rapids)(図3)は、CPUそのものを最大64コア集積したデータセンター向けのSoCである。第4世代のXeonスケーラブルプロセッサと比べ、平均的な性能は1.21倍、AIの推論性能は最大1.42倍などの改良が加えられている。

性能向上のカギはメモリである。メモリ速度を高めると共に、CPUから最も遠いキャッシュメモリであるLLC(Last Level Cache)のサイズを前世代の3倍に増やした。メモリの転送レートは最大5600MT/sで、LLCメモリの大きさは最大320MBもある。CPUあたり8チャンネルのDDR5をサポートし、CPU間のUPI(Ultra Path Interconnect)2.0対応速度は最大20GT/sと高速になった。このチップは2024年第1四半期から発売される予定となっている。

図4 第5世代Xeonスケーラブルプロセッサ(右手)とCore Ultra(左手)を持つインテル代表取締役社長の鈴木国正氏

Intel日本法人インテル代表取締役社長の鈴木国正氏は、クラウド上でのAIアクセラレータとして、2024年発売の新製品Gaudi 3に関しても触れたが、Intel 5プロセスを使う予定であることだけにとどめた。現在使われているGaudi 2と比べBF16演算性能が4倍、ネットワーク帯域幅が2倍、HBM帯域幅が1.5倍にそれぞれ増えるとしている。また、AI Everywhere戦略の究極はエッジにおける組み込みシステムになるだろう、と同氏は予想する。IntelはクラウドからエッジまでAIを活用できる体制を整えることになりそうだ。

参考資料

1. 「SiCトップのSTMicro、パワーだけでなくエッジAI含めソリューションで勝負」、セミコンポータル (2023/08/09)

2. 「AIチップ、クラウドの生成AIからエッジでの専用的な生成AIへ拡大」、セミコンポータル (2023/10/10)