AIの学習・推論に強いNvidiaが生成AIでも強い理由

Nvidiaが半導体メーカーの中で唯一、時価総額1兆ドルを超えた。同社の2024年度第1四半期(2023年2〜4月期)の売上額はまだ前年の金額にも達しなかったにもかかわらず、次の四半期売上額を前四半期比53%増の110億ドルとの見通しを発表したためだ。その原動力は生成AI向けのGPUだ。特に最高性能のH100というGPUの供給が足りないため、生成AI業者はチップを製造するTSMCから順番待ちを強いられている。

図1 文脈を理解して新しいコンテンツを生成する生成AIの位置づけ 出典: Nvidia

これほどまでなぜNvidiaフィーバーが起きているのか。Nvidiaの強さはGPU(グラフィックスプロセッサ)だけではない。GPU搭載コンピュータシステムとAIに応用するためのソフトウエアも提供する。また、H100は単なるGPUではない。生成AI(図1)に必要な大規模言語モデルを構築するためのトランスフォーマーエンジンを集積しているという。すなわち、生成AIに向いた専用回路を集積している。

24年度第1四半期のNvidiaの業績は、売上額だけを見るとさほど目立ったものではなかった。前四半期比で19%増とは言っても前年同期比では13%減というマイナスの71.9億ドルにすぎなかった。ただ、売上額のボトムであった2023年度第3四半期(2022年8~10月期)からは徐々に上昇してきてはいる。それが次の四半期見通しが53%増±2%という驚異的な見通しを示したため、業績発表後の株価は急騰し、時価総額が1兆ドルに迫り、その後超えた。

バンク・オブ・アメリカのアナリストは、ITメジャーをもはやGAFAMでは表現できず、Google、Amazon、Facebook (Meta)、Apple、MicrosoftにTeslaとNvidiaを加え、Magnificent Seven(偉大な7社)と表現した。実は、Magnificent Sevenという名称は、1960年代の映画「荒野の七人」の原題である。農民のためにならず者たちと戦った勇気ある7人をたたえた、黒澤明監督の「七人の侍」をモデルとしている。

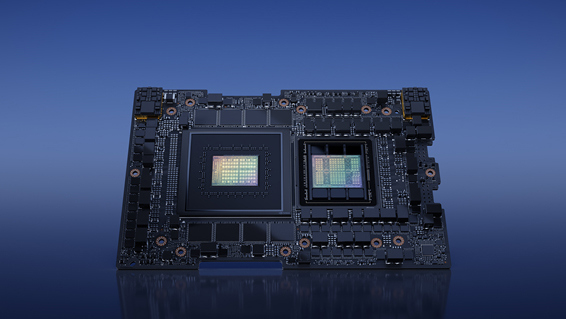

Nvidiaは目の前のH100というGPUの生産だけに集中しているのではない。H100の次世代版とでもいうべき、GH200というCPUとGPUを1パッケージに搭載しSuperchipと表現された「Grace Hopper」(図2)の試作も発表し、次のレベルの生成AIにも対応していることを最近のComputex-Taipeiで発表している。この最新チップ「Grace Hopper」では1兆パラメータの大規模言語モデルにも対応できるという。ChatGPTに使われたGPT-3では1750億パラメータというとてつもないと思われた大規模言語モデルのさらに一桁大きな巨大なモデルの学習も可能にするチップである。

図2 最高性能を備えた新しいSuperchipの「Grace Hopper」 Computex Taipeiで発表され今年年末までに出荷される予定 出典:Nvidia

Grace HopperはCPU(Grace)とGPU(H100)を一つのパッケージに搭載した巨大なチップであるが、チップサイズをNvidiaは公開していない。CPUにはArm Neoverse V2コアを72個集積しており、GPUとはPCIe 5.0よりも7倍高速のNVLink-C2Cでつながっており、900GB/sというバンド幅を実現している。GPUのメモリとCPUのメモリ内容が同じというメモリコヒーレンスも実現している。

トランスフォーマーエンジンとは、生成AIを実現するためのトランスフォーマーモデル専用回路で、入力される言語を理解するエンコーダ回路と、言語を生成するデコーダ回路からできている(図3)。いずれの回路とも入力データを各部分に分解しそれぞれの重要度に応じて重み付けされるアテンションメカニズムを導入したディープニューラルネットワークモデルである。

図3 トランスフォーマーエンジン 入力される言語を理解するエンコーダ回路と、言語を生成するデコーダ回路で出来ている 出典:Nvidia

デコーダ、エンコーダ内部の各レイヤーの処理を何ビットで演算するのか、FP16(16ビットの浮動小数点)かFP8(8ビットの浮動小数点)か、を適切に切り替えることで、処理速度と精度のバランスをとりながら、大規模言語モデルに対応しているという。ここにNvidiaのノウハウがあるようだ。

Nvidiaは、クラウドを通じてAIトレーニングサービスを提供しており、性能向上を支援する同社のAIエキスパートの支援も受けられる。Microsoft AzureやGoogle Cloudなどを通じて提供される。データ収集から始めて生成AIモデルを構築し、学習やモデルのカスタマイズ、推論の高速化に加え、不適切な情報(偏りと毒性)を排除し意図に沿った情報だけを守るガードレールまで行うNeMoフレームワークもクラウドベースで提供している。

Nvidiaは、もはやファブレスチップ設計企業から、モジュールやサーバーも設計し、それらをつなげて拡張するネットワークチップやインターフェイスも提供し、スーパーコンピュータを実現するための支援も行うコンピュータメーカーになったといえそうだ。